PSX22 escribió:@Cyborg_Ninja

De toda esa biblia me he leido una linea solo y era una barbaridad de la desinformacion de nuevo

PSX22 escribió:Mayban36 escribió:

De toda esa biblia me he leido una linea solo y era una barbaridad de la desinformacion de nuevo

![idea [idea]](/images/smilies/nuevos2/idea.gif)

Cyborg_Ninja escribió:PSX22 escribió:Mayban36 escribió:

De toda esa biblia me he leido una linea solo y era una barbaridad de la desinformacion de nuevo

Cuanta educación, gracias.

Sigo esperando esas demostraciones de juegos que tienen mejores texturas usando una Nvidia que una AMD.

Indeed, images demonstrated by Nvidia clearly show that NTC is better than traditional Block Coding-based technologies. However, Nvidia admits that its method is slower than traditional methods (it took a GPU 1.15 ms to render a 4K image with NTC textures and 0.49 ms to render a 4K image with BC textures), but it provides 16x more texels albeit with stochastic filtering.

Mr.Gray Fox escribió:@PSX22 NTC no se está usando, es una prueba de concepto que no ha llegado a ningún sitio por ahora. Lo cual desmiente que los juegos se vean mejor en una nVidia, ya que actualmente no se está usando en ninguna parte.

Y es un parche puesto precisamente tras sacar una gama entera de gráficas bastante limitadas en cuanto a VRAM. Puedes usar toda la compresión que quieras (cosa que NO OCURRE a día de hoy), para paliar la falta de VRAM en ciertos momentos, pero esa compresión no viene gratis, tardas casi el doble de tiempo en cargar el resultado final:

https://www.tomshardware.com/news/nvidi ... ion-methodIndeed, images demonstrated by Nvidia clearly show that NTC is better than traditional Block Coding-based technologies. However, Nvidia admits that its method is slower than traditional methods (it took a GPU 1.15 ms to render a 4K image with NTC textures and 0.49 ms to render a 4K image with BC textures), but it provides 16x more texels albeit with stochastic filtering.

Nunca he dicho que los juegos se vean mejor, sino que las texturas se ven mejor y la tecnologia es mejor, que se use o no no nos importa a nadie,el debate es quien tiene mejor grafica netamente.

Y tampoco es muy dificil de imaginar que si tienes algo mejor pueda aplicarse a usos reales que si no lo tienes

Es totalmente falso que esa tecnologia sea un parche, da mas calidad ocupando menos, cuando se use la 5090 va a usarla y no por falta de vram xd

Otra falsedad es que actualmente nvidia usa la misma memoria, usa menos y no neceista compresión avanzada, para hacerlo, usan la normal pero es distinta como se muestra en nvidia, es algo que hoy puedes comprobar con una de cada y mismos ajustes graficos

Simplemente la reserva de vram por el driver es distinta y no es raro que amd use 1-2GB extra

Mr.Gray Fox escribió:@PSX22 Vale, vamos a ponernos quisquillosos. Dices que las texturas se ven mejor, cuando ACTUALMENTE NTC no se está usando en ninguna parte por ser tremendamente costoso comparado con los métodos más tradicionales. Te he pasado un enlace de tomshardware (página que junto con anandtech son de lo más fiable que existe) pero recuerdo haber visto en algún sitio que esa misma penalización de tiempos era con las pruebas en una 4090. Si la gráfica más potente del mercado de consumo tarda el doble de tiempo en procesar texturas, ya te imaginarás lo que tardarán el resto de las 4000.Nunca he dicho que los juegos se vean mejor, sino que las texturas se ven mejor y la tecnologia es mejor, que se use o no no nos importa a nadie,el debate es quien tiene mejor grafica netamente.

Vuelves a lo mismo, las texturas se ven mejor y la tecnología es mejor. Pero ya te he dicho que no se usa en ninguna parte, ni se la espera. Dame pruebas, una prueba a ciegas en la que se vea que una gráfica de AMD muestra texturas peor que una de nVidia. Y no me vale un paper de NTC, quiero pruebas REALES.Y tampoco es muy dificil de imaginar que si tienes algo mejor pueda aplicarse a usos reales que si no lo tienes

Cuando se usen, que ya veremos si se usan, veremos la diferencia. Mientras tanto, me remito al refranero sobre tener un tío en Alcalá, que ni tiene tio ni tiene nah.Es totalmente falso que esa tecnologia sea un parche, da mas calidad ocupando menos, cuando se use la 5090 va a usarla y no por falta de vram xd

Da más calidad, ocupando menos, y con un coste computacional mayor. Con lo cual te quedas casi en lo mismo, las únicas gráficas que van a poder usarlo sin sufrir demasiado en rendimiento serán precisamente las que no tienen ese problema. Así que sirve para realmente poco en apartado de juegos.Otra falsedad es que actualmente nvidia usa la misma memoria, usa menos y no neceista compresión avanzada, para hacerlo, usan la normal pero es distinta como se muestra en nvidia, es algo que hoy puedes comprobar con una de cada y mismos ajustes graficos

De nuevo, pruebas a ciegas. nVidia usa menos VRAM, porque sus modelos de gráficas vienen con menos VRAM y los motores gráficos convencionales (UE y Unity mayormente) siempre reservan ligeramente por encima de lo que realmente necesitan. Cosas de no picarse uno mismo un motor gráfico, ganas en tiempo de desarrollo pero lo pierdes en optimización en ocasiones. Tampoco es que sea experto en esto, ya que mi conocimiento programando un motor gráfico desde 0 ha sido bastante guiado y hay muchas cosas que no entiendo realmente en cuanto pasamos al 3D.Simplemente la reserva de vram por el driver es distinta y no es raro que amd use 1-2GB extra

Esto no te lo discuto, el uso de VRAM de base en AMD es más alto incluso en escritorio de Windows, pero depende enormemente de la gestión del SO. Al margen de juegos, hay modelos de IA que cargados en mi gráfica entran o no dependiendo del SO en el que me encuentre, y siempre a favor de GNU/Linux.

PSX22 escribió:@Mr.Gray Fox

Le puedes dar las vueltas que quieras la tecnologia es mejor, dlss no esta en todos los juegos tampoco pero la gpu nvidia es mejor, como si la dejas precintada la gpu, sigue siendo mejor. El poder esta ahi. Y en cualquier momento puede despertar , en amd no va a pasar.

Basta ya de comprar para dentro de 5 años porque lo mas normal es que ya tengas un PC nuevo

Repito en nvidia el uso en juegos actuales la Vram es menor, que alguien explique porque si es el mismo juego

Simplemente la reserva de vram por el driver es distinta y no es raro que amd use 1-2GB extra

Esto no te lo discuto, el uso de VRAM de base en AMD es más alto incluso en escritorio de Windows, pero depende enormemente de la gestión del SO. Al margen de juegos, hay modelos de IA que cargados en mi gráfica entran o no dependiendo del SO en el que me encuentre, y siempre a favor de GNU/Linux.

PSX22 escribió:@Mr.Gray Fox

Le puedes dar las vueltas que quieras la tecnologia es mejor, dlss no esta en todos los juegos tampoco pero la gpu nvidia es mejor, como si la dejas precintada la gpu, sigue siendo mejor. El poder esta ahi. Y en cualquier momento puede despertar , en amd no va a pasar.

Repito en nvidia el uso en juegos actuales la Vram es menor, que alguien explique porque si es el mismo juego

PSX22 escribió:@Mr.Gray Fox

Pero tu como te puedes tomar en serio a amd si no tiene en la era de la IA una solucion IA por hardware?

Pero que hasta intel la supera tienen Xess con hardware, amd usa lo mismo en u a 7900xtx que en steam deck FSR todo software xd

PSX22 escribió:@Mr.Gray Fox

Pero tu como te puedes tomar en serio a amd si no tiene en la era de la IA una solucion IA por hardware?

Pero que hasta intel la supera tienen Xess con hardware, amd usa lo mismo en u a 7900xtx que en steam deck FSR todo software xd

Mr.Gray Fox escribió:PSX22 escribió:@Mr.Gray Fox

Pero tu como te puedes tomar en serio a amd si no tiene en la era de la IA una solucion IA por hardware?

Pero que hasta intel la supera tienen Xess con hardware, amd usa lo mismo en u a 7900xtx que en steam deck FSR todo software xd

No cambies de tema, y desde luego no pongas palabras en mi boca que yo no he dicho. Tampoco mientas, porque AMD sí tiene aceleración de IA, y te lo demuestro cuando quieras hasta en Windows. ¿Te suena ROCm? Porque llevo ya unos cuantos meses usando Stable Diffusion en local con mi gráfica, cargando LLMs para trabajar con chatbots en local y no tener que depender de GPT3.5 cuando la información es sensible. Y modelos relativamente grandes, donde la cantidad de VRAM es algo que te permite cargar o no un modelo.

Y si quieres llevarlo al terreno de juegos, tanto FSR como XeSS son soluciones de SOFTWARE, por eso se pueden usar en todas las gráficas disponibles del mercado. Afirmas categoricamente que el DLSS es superior, y lo es, con varios peros:

1º Es una solución propietaria, lo que obliga a que si quieres usarla, te toca pasar por el aro y los precios de nVidia.

2º FSR es abierto, y CUALQUIER desarrollador puede modificarlo para mejorarlo según los parámetros de su juego. Puedes comprobarlo mirando análisis del No Man's Sky, donde la implementación del FSR 2.0 es algo personalizado y mejora notablemente. Otra cosa es que otros estudios usen FSR como un parche que automáticamente te hace ganar rendimiento a costa de perder calidad.

Aparte, como punto final al asunto de FSR (que entiendo por qué lo sacas, te has quedado sin argumentos con el tema de las texturas y estás haciendo una huida hacia adelante tratando de buscar otra cosa sobre la que quejarte), he pasado incontables horas probando configuraciones tanto de XeSS como de FSR en varias zonas de Cyberpunk 2077, y lo que he llegado a ver no es que XeSS lo haga mejor, es que su modo de máxima calidad parte de una resolución superior al modo de más calidad de FSR. Conforme vas bajando los niveles de reescalado, parece que van interpolándose entre ellos.

La cosa sería así, de más calidad a menos (no recuerdo exactamente los nombres de los presets que usa por ejemplo Cyberpunk 2077)

XeSS -> Ultra calidad

FSR -> Calidad

XeSS -> Calidad

FSR -> Equilibrado

XeSS -> Equilibrado

FSR -> Rendimiento

XeSS -> Rendimiento

XeSS -> Ultra rendimiento

FSR -> Ultra rendimiento

Ya no me meto en el tema de FSR3, no he podido probarlo ya que los juegos que lo implementan no me interesan lo más mínimo. Cuando tenga datos sobre los que opinar, lo haré, mientras tanto, no voy a hablar de lo que no he podido probar en primera persona.

ScrollSpeed escribió:La gente se queja que AMD no vende porque pone mismo precios que Nvidia ,pero si vas a las tiendas en la mayoría de gamas están muy por debajo en precios en GPU equivalentes o superiores, la 7900GRE por ejemplo tiene un precio/rendimiento y la gente preferire pagar más por una 4070S.

Esto nos lleva que la gente compra simplemente por marca, da igual si hay mejores alternativas , y eso será imposible superar para AMD a menos que la marca se devalúe como le pasó Intel en CPU que se durmieron y tropezaron, aprovechándolo AMD, aun así Intel todavía vende bien por marca. En Nvidia veo muy difícil que tropiezen con alguna arquitectura, y mientras eso no pase por más que AMD saque algo mejor y mitad de precio, Nvidia seguirá vendiendo más.

Yo es que no le veo sentido que una RTX3060 este en top de Steam y no uns 6700 XT que se puede encontrar al mismo precio con mejor rendimiento y mas Vram, pero es que la 6700xt no entra en el Top 10 de steam....

eduardo+++ escribió:es de entender el compañero tiene una 4070 por eso la defiende a capa y espada

como cuando le dicen a un tipo tu mujer es fea! claro el tipo salta la defiende diciendo que es guapa y con toda razon pues es su mujer , se la esta montando de lo rico

Cyborg_Ninja escribió:eduardo+++ escribió:es de entender el compañero tiene una 4070 por eso la defiende a capa y espada

como cuando le dicen a un tipo tu mujer es fea! claro el tipo salta la defiende diciendo que es guapa y con toda razon pues es su mujer , se la esta montando de lo rico

Nah, pero esas actitudes se suelen pasar cuando se alcanza la madurez mínima.

Yo tengo una 7800XT y yo se que es meterle Ray Tracing a un juego y se queda en una 4060 con mucha suerte. También se que el DLSS tiene mejores resultados que el FSR.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Duendeverde escribió:Mi opinión. AMD se fue de madre cuando a partir del 2015, Su CEO cambió su política de no vender barato. A partir de ahí, como mucho competía con la gama media. La gama alta era basura y cara para lo que ofrecía. Le salvaron los muebles las dos crisis mineras que llegaron después.

Si bien ya no estamos en tiempos de la fury y ésas. Siguen por debajo. Tanto en rendimiento, como en software y tampoco son nada baratas de salida.

Recuerdo en 2013, como una rebajada HD 7950 boost con algo de overclock, rendía similar a la gtx 670, que costaba 150€ más. Eso ya no ocurre, a no ser que AMD venda poco o nada.

Si vendes algo un 20% más barato, pero sin RT real, sin cuda.., Pues el que se deja dinero, va por lo seguro.

Además en software van por detrás. Todas tienen drivers malos. Pero AMD se toma mucho tiempo en reparar los fallos. Además, su soporte es mayor. Una gtx 970 sigue teniendo soporte en drivers recientes. Incluso la 750 ti. Pero AMD ya quitó a las RX 400 y 500 y pasó a legacy. Las de la época de la 970, incluso hace 3 años.

AMD es mejor en software únicamente en linux. Pero dudo que la mayoría se compre una 7900xt para jugar ahí la verdad.![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Nvidia es mejor en rendimiento, tecnologías y sobre todo saber venderse. Además su nicho de mercado es ya gama x60 para arriba. Pero sus mayores ingresos son por IA

AMD va mejor en apus. Así lo demuestra con las consolas, steam deck y chips gráficos integrados. Creo que AMD debería centrarse más en ese nicho de mercado, que no competir contra Nvidia, con gráficas estufas de miles de euros.

AxelStone escribió:@ScrollSpeed Te comento un poco el mito de los drivers, que no es tan mito lo que pasa es que a dia de hoy funcionan bastante bien.

Los drivers de AMD tradicionalmente han ido a remolque de nVidia, siempre han requerido varias iteraciones para ponerse al nivel. Hay casos curiosos como la GT1030 vs la RX550 que si ves las primeras comparativas parecía que la GT1030 rendía más pero a medida que AMD refinaba drivers, la RX550 la superó. A día de hoy está claro que es mejor tarjeta, pero no fue la primera impresión y todo por culpa de los drivers.

La moda ahora es el FSR y el DLSS, donde una vez más nVidia ha ganado ventaja. Con el tiempo estoy seguro que ambas soluciones estarán al mismo nivel, pero siempre es nVidia la que golpea primero.

A eso se refiere el famoso "problema" de drivers.

.

.AxelStone escribió:@ScrollSpeed Te comento un poco el mito de los drivers, que no es tan mito lo que pasa es que a dia de hoy funcionan bastante bien.

Los drivers de AMD tradicionalmente han ido a remolque de nVidia, siempre han requerido varias iteraciones para ponerse al nivel. Hay casos curiosos como la GT1030 vs la RX550 que si ves las primeras comparativas parecía que la GT1030 rendía más pero a medida que AMD refinaba drivers, la RX550 la superó. A día de hoy está claro que es mejor tarjeta, pero no fue la primera impresión y todo por culpa de los drivers.

La moda ahora es el FSR y el DLSS, donde una vez más nVidia ha ganado ventaja. Con el tiempo estoy seguro que ambas soluciones estarán al mismo nivel, pero siempre es nVidia la que golpea primero.

A eso se refiere el famoso "problema" de drivers.

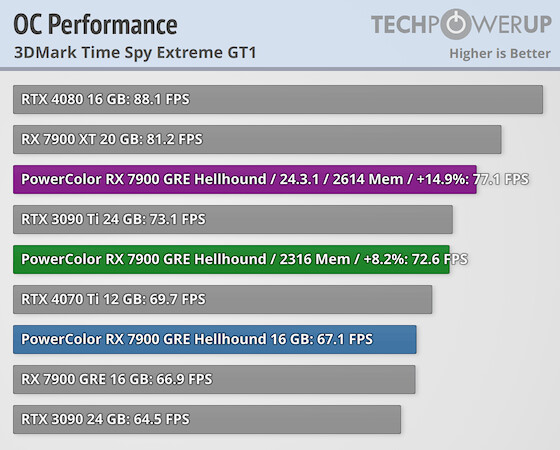

ziu escribió:Hola una 7900gre con overclock (GPU y RAM)se q casi iguala a la 7900xt,

Es la mejor gráfica actualmente calidad/precio de esta manera?

https://videocardz.com/newz/amd-enables-memory-overclocking-on-radeon-rx-7900-gre

Saludos!

MrKafka escribió:ziu escribió:Hola una 7900gre con overclock (GPU y RAM)se q casi iguala a la 7900xt,

Es la mejor gráfica actualmente calidad/precio de esta manera?

https://videocardz.com/newz/amd-enables-memory-overclocking-on-radeon-rx-7900-gre

Saludos!

Para mi, si, es la mejor. Y si hubiera estado cuando yo me compré la 7900 XT, hubiera elegido la primera y me hubiera ahorrado 200€ y casi el mismo rendimiento. Tambien es verdad que con el mismo OC, la 7900 XT se despega mas aún.

TotalEvilDead escribió:@Silicio14mm

Hay muchos reportes afirmando que esos 110 grados son debidos a la degradación de la pasta térmica y de diseño, por lo que para mí es un problema. Además que pienso que si hay thermal throttling algo no va bien aunque te vendan unas velocidades inferiores.

Y volviendo a los 110 grados, seguros? Según ellos si, pero que es una temperatura muy alta no es una percepción del consumidor, es que lo es en comparación con lo demás.

Ojo que no digo que eso sea una chapuza, ojalá tuviera una 7900xtx, pero es un defecto probado y hay que decirlo. Igual que hay que decir que el conector de la 4090 es propenso a fallar por mucho que los fanáticos digan que el usuario lo conecta mal.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

. Recuerdo estar haciendo el mod a una Master System 2 (ha llovido) que no recuerdo sin montaba disipación pasiva o sencillamente no montaba nada (un Z80 igual no necesita refrigerarse, como digo no lo recuerdo).

. Recuerdo estar haciendo el mod a una Master System 2 (ha llovido) que no recuerdo sin montaba disipación pasiva o sencillamente no montaba nada (un Z80 igual no necesita refrigerarse, como digo no lo recuerdo).